12月も半ばを過ぎ、2025年も残すところあとわずかとなりました。毎年言っている気もしますが、今年のIT業界、特にAI周辺(界隈という言葉は使いたくない)のスピード感にはもう、ついていけない感じでした。

さて、毎月Googleさんに関連するよもやま話をお届けしているこの連載「Google Tales」も、今年最後の更新です。今回は激動の2025年の、GoogleのAIについて大まかに振り返ってみます。

Geminiに尋ねたところ、2025年は「AIが、チャットボットという『箱』から飛び出した年」と総括してくれました。

■ なんといっても「Gemini 3」

年初のころのAIとの付き合い方は、まだ「いかに上手なプロンプトを書いて、綺麗な絵を出力させるか」とか「自然な日本語で会話できるか」とかに一喜一憂するものでした。

それが、11月に発表された「Gemini 3」と「生成インターフェース」で、使い方が大きく変わりました。

これまでは、AIくんにわかりやすいよう気遣いつつテキストボックスにプロンプトを入力することで会話を続けていました。が、Gemini 3では、会話の流れに合わせて、AI側が勝手にUI(画面)を作り変えてきます。

まだプレビュー段階ですが、「動画ビュー」を使えば、例えば「旅行の計画を立てて」と頼むとチャット欄が消えて、地図とスケジュール表と予約ボタンが統合された専用アプリのような画面が生成されます。

▲動画ビューで旅行プランを相談した(この画像の右上のプロフィール画像のマスキングもGeminiにやってもらいました)

今のところは、ホテルの予約まではできませんが、Google検索で自分で調べるよりかなり便利です。

また、Geminiアプリではまだ使えない開発者プレビュー版ではありますが、10月に登場した「Computer Use」機能も、エージェントっぽいなぁと思いました。AIがコンピュータの画面を認識し、クリックやキーボード入力などのUIアクションを生成してWebブラウザを操作する、というものです。

例えばどんなことに使えるのかGeminiに尋ねたところ、「空気清浄機を買いたい。予算5万円までで、Amazon、楽天、ヨドバシで最もレビュー評価が高く、明日届く商品を見つけ、購入ボタンを押す手前まで進めておいて」とか「引っ越しが完了したので、登録しているすべてのサービスの住所を新しいものに変更して」とかの指示を紹介してくれました。

すごくない? 2025年は、AIが話し相手からエージェントへと成長していく元年といっても過言ではないでしょう。

■NotebookLMにはお世話になりました

2023年に発表され、2024年から日本でも使えるようになっている「NotebookLM」も2025年に随分進歩しました。世の中ではポッドキャストのような「音声解説」が話題になっていますが、個人的には放り込んだソースのみに基づいて解説してくれる機能を、仕事で多用しました。11月には、後述する「Deep Research」も使えるようになり、ますます便利に。

また、6月に追加されたノートブックの一般公開機能、あまりめぼしいノートブックはないなぁと思っていましたが、The Economistの「The World Ahead 2025」(英語)などは、全部読まなくても内容について日本語で質問すると日本語で説明してくれるので、勉強させてもらいました。

▲The Economistのノートブック

■ OpenAIにはない、Googleの強みは?

OpenAIの「Sora 2」(発表は9月30日)が評判になればGoogleが11月30日に「Nano Banana」を出し(そしてOpenAIが12月16日に「ChatGPT Images 1.5」を出し)、Googleが11月19日に「Gemini 3」を出せばOpenAIは12月11日に「GPT-5.2」で対抗する、と、2025年を通して両社はしのぎを削ってきました。

Geminiに、OpenAIにはないGoogleの強みは何か尋ねてみました。

答えは、Googleは「脳(Gemini)」だけでなく、「目(Lens/カメラ)」と「手足(Android/Pixel)」を持っていること、でした。

例えば「Pixel Watch」にGeminiが常駐することで、いつでもどこでもGeminiと会話できます。

▲Pixel Watchになんでも質問できます

また、日本ではまだ使えませんが、米国ではGeminiがGoogleマップでも使えるようになっていて「あのお店の雰囲気、デートに向いてる?」と聞くと、レビューと動画を解析して「騒がしいので不向きかも」と教えてくれるそうです。Googleはマップや検索などに蓄積されている膨大なデータをAIに活かせるのが強みです。日本でもGeminiからならGoogleマップのレビューに基づいたレコメンドをしてもらえます。

そして、「スマホの次」として見逃せないのが「Android XR」です。

12月の発表で、Samsungの「Galaxy XR」だけでなく、XREALのAIメガネも2026年には発売になることが判明しています。

▲XREALのProject Aura

ここでも主役はGeminiです。XRグラスやヘッドセットのカメラを通じて、Geminiがユーザーの「視界」を共有する。目の前の壊れた自転車を見れば修理方法が空間に浮かび、外国語のメニューを見れば翻訳が表示される。 わざわざスマホを取り出してアプリを起動する必要がなくなります。この「現実世界にAIが情報のレイヤーを重ねる」体験を手持ちの札で提供できるのは、Googleの強みでしょう。

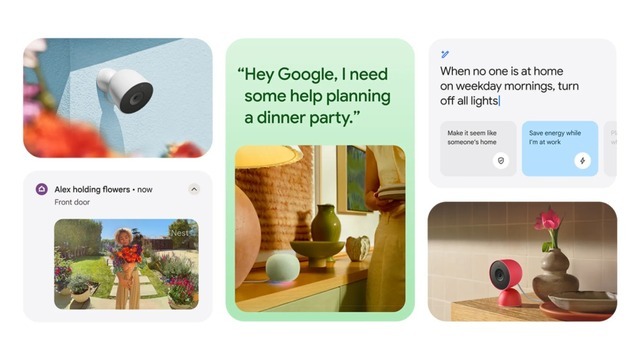

■ 「家」そのものがAIになる未来(Nestの進化)

Google自身も忘れているんじゃないかと心配していたスマートホーム「Nest」周りにも動きがありました。現在はまだプレビュー段階としての公開ですが、「Gemini for Home」が始動しており、日本でも2026年初頭には関連機能の提供が始まると公式のアナウンスがありました。

▲初頭というのはいつ頃のことかな~

これまでのスマートホームは、「ねぇGoogle、電気を消して」などの明確な命令が必要でした。しかし、現在テストされているGemini統合版のNestが目指しているのは、「文脈理解」です。

▲まずは、今GoogleアシスタントなスマートホームデバイスのアシスタントがGeminiになる予定

例えば、正式版ではこんなことができるようになるそうです。

夜、リビングで「そろそろ寝ようかな」と独り言のように呟くだけで、AIが「yukiが就寝モードに入った」と理解し、照明を落とし、エアコンの温度を調整し、翌朝のアラームを確認し、玄関の鍵が閉まっているかを確認して「おやすみなさい。明日は雨なので少し早めに起こしますか?」と提案してくるようになる(はず)。

Googleが目指す「アンビエント・コンピューティング(環境に溶け込むコンピュータ)」です。個人的には、うっかり独り言もつぶやけないのは嫌だなぁと思うので、やっぱりウェイクワードはあっていいかな。

■ 「調べる」苦役からの解放

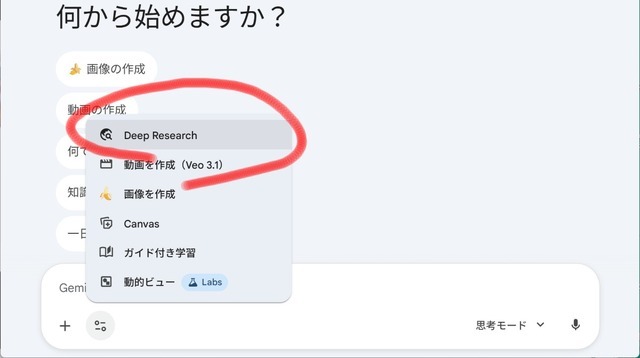

ライター稼業にとって(そして多くのデスクワーカーにとって)今年最大の恩恵だったかもしれない機能、「Deep Research」も忘れちゃいけません。

▲これです

私は普段はコラムではなくて、海外速報を担当しているライターです。考察はあまりせず、正確な情報をなるべく速く集めて、事実のみをニュースとして伝えるというお仕事。

ニュースの背景にあるそれまでの経緯や関連情報を探していて、気づくとChromeブラウザのタブがずらっと並ぶことが多いです。例えば「Pixel 10」シリーズが出たら、Pixel 9やiPhoneやGalaxyの最新モデルと比較するためにそれぞれの公式スペックのページを表示したり、Pixel 10の機能について説明しているわかりやすい画像を探したり。

Geminiに尋ねたところ、「Deep Researchなら、『Pixel 10 Proと、過去のPixel 6~9 Pro、およびiPhone 17 Proのカメラ仕様(センサーサイズ、画素数、絞り値)とバッテリー容量、充電速度を比較する表を作成して。ソースは必ず公式サイトか公式ブログを参照すること』 と投げれば、PDFのマニュアルや過去のプレスリリースを掘り起こして埋めてくれます。不明な箇所は勝手に埋めず『記載なし』としてくれる信頼感もポイントです。」というお返事でした。実際にやってみたら、そううまくは行きませんでしたが。

なんでまだうまくいかないかというと、Geminiの今の学習データ(知識ベース)における情報のカットオフ(期限)が、概ね2025年1月頃なので、「Pixel 10 ProおよびiPhone 17 Pro につきましては、現時点ではメーカー公式サイト等での正式な仕様(スペック)情報の公開が確認できない」のでした。もうしばらくは単純速報ライターが干されることはなさそうです。

それでも、「PixelとGalaxyとiPhoneの最新モデルが発表されたのがいつかそれぞれについて教えて」とか、細かい確認は任せられるようになって(なぜかそういうときは2025年1月より後の情報もちゃんと表示する)、それだけでもかなり助かっています。

■ 2026年、翻訳の精度が上がり、「火星の女王」的会話が可能に(?)

そして、このコラムを書いていたら、また新しい発表が。Google翻訳のエンジンが、本格的にGeminiベースに切り替わるという発表です。日本で2025年中に使えるようになるわけではないようですが、初期対応言語に日本語が含まれています。

このGeminiが統合された新しいGoogle翻訳は、文脈を理解し、ジョークはジョークとして、皮肉は皮肉として、適切な「温度感」で翻訳するんだそうです。公式ブログでは、常套句の「stealing my thunder」をこれまでは「私の雷を盗んだ」と翻訳していたところ、新Google翻訳では本来の意味である「私の手柄を横取りした」と訳すようになる、という例を紹介しています。

こうした常套句もですが、米国のメディアの個性的でアクの強い人気ライターさんの文章は皮肉や暗喩だらけなので、Google翻訳に訳してもらっても、「?」と思う都度そこを原文に当たりながら読んでいましたが、その必要がなくなるのかも。

現在は米国とインドからの先行順次ロールアウトされる予定ですが、これが日本で使えるようになれば、海外記事の翻訳作業はかなり楽ちんになりそうです。というか、ストレートニュースの翻訳稼業はお払い箱になるかも。

また、Pixel Budsなどのイヤホンで実現するリアルタイム翻訳も2026年にはかなり実用的になりそうです。今、NHKで小川哲さん原作の「火星の女王」のドラマを放映中なんですが、そこで多国語での会話を自動翻訳で交わしているシーンが出てきます。Googleが紹介したデモ動画では、それと同じような会話が交わされています。これが日本語にも対応したら、海外旅行がかなり楽しくなりそう。

■ 2026年は「信頼」が鍵に

あとは、どこまでAIを信用して、タスクを丸投げできるかが鍵になりそうです。今のところ、記事を書くのにもいろいろ助けてもらってはいますが、結局自分でも全部確認して文体も修正しているので、時短にはあまりなっていません。

それでも近いうちに、速報記事は全部Geminiくんにおまかせできるようになるかもしれません。ちなみに、このコラムもGeminiくんに相談しながら書きました。毎日縁側で茶をすする、憧れのご隠居生活がそろそろ見えてきました。

それでは皆様、よいお年を!

▲Geminiにまかせて縁側でまったり(イラスト:ばじぃ)