3Dポリゴンやでできたキャラクターがリアルタイムで動くVチューバーがいま広まっています。こうしたキャラクターを動かす際、口の動きをどう表現するかという問題に直面します。

Vチューバーのようなリアルタイムでなくとも、口の動きをつける需要は増大しています。3Dポリゴンや2Dのイラストで描かれたキャラクター達が、喋る言葉によって口の動きが変わるというのは今やゲームや動画制作で当たり前となっているからです。

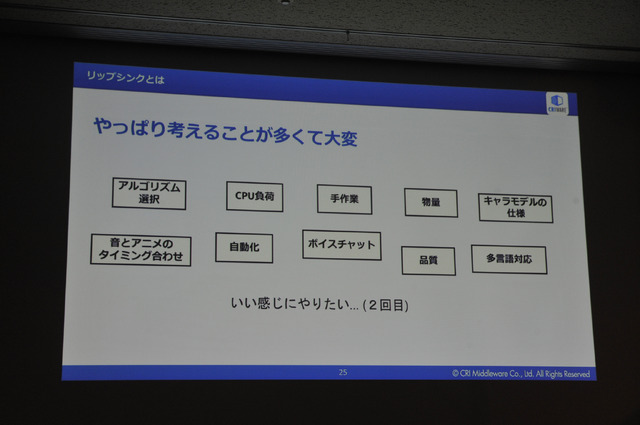

こうした口に動きをつけることを「リップシンク(口パク)」と言いますが、これを手作業でやるとなると、2D・3D問わず地道な作業が求められます。最後は職人技のような調整が光りますが、こうした作業をなるべく自動化する取り組みが近年盛んです。こうしたソフトウェアを「リップシンクミドルウェア」とも言います。

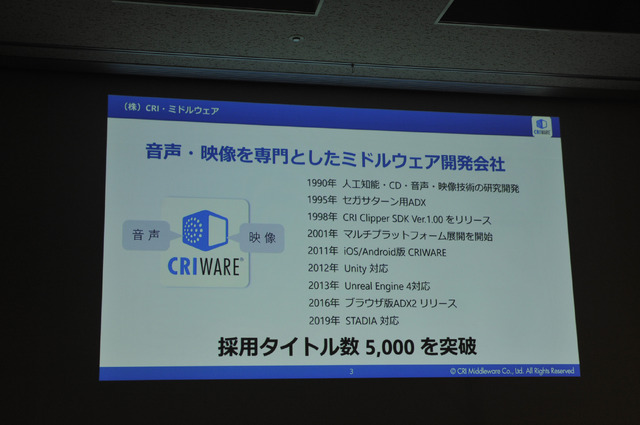

最新の「リップシンクミドルウェア」はどのような技術によって支えられているのでしょうか。9月4日にパシフィコ横浜で開催した「CEDEC 2019」のセッション「キャラクターをより魅力的に!ゲーム向けリップシンクミドルウェア」にて、音と映像のミドルウェアを開発するソフトウェア会社「株式会社CRI・ミドルウェア」の技術者・柴田修作さんが解説しました。

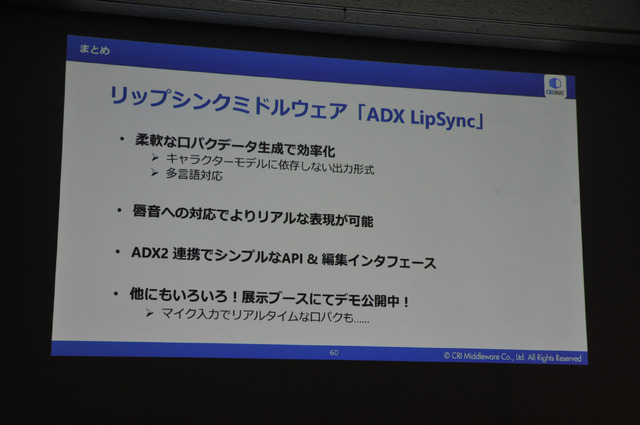

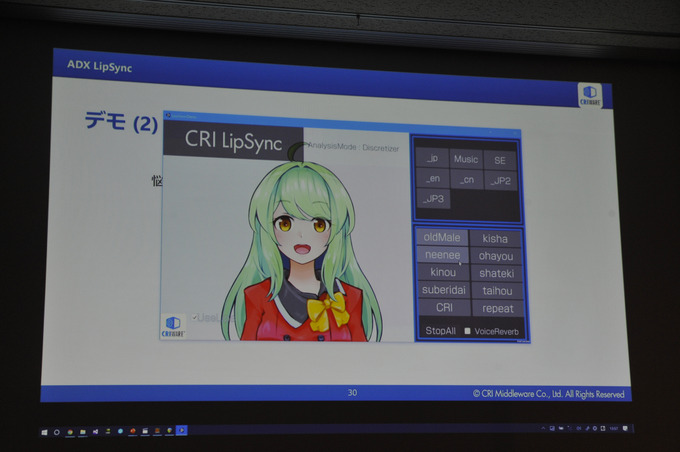

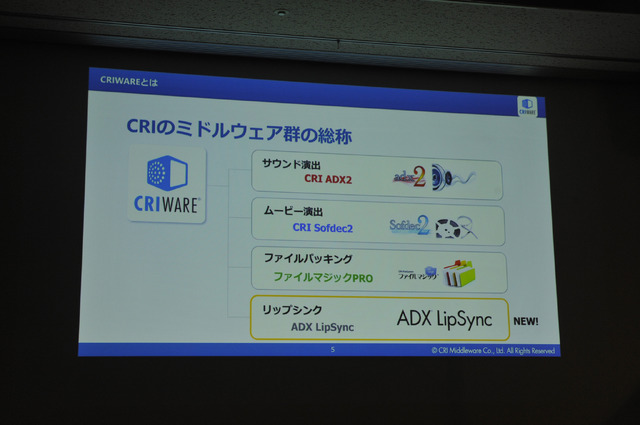

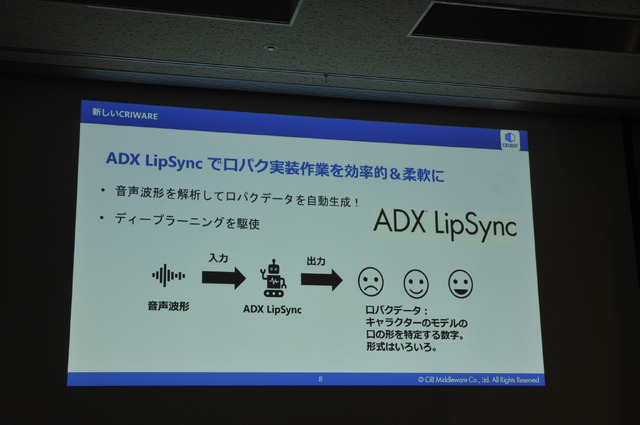

「近年は多言語対応が求められており、口パクは一層煩雑さを増している。口パクの実装作業をいい感じに効率的にやって欲しいという需要が増している」と最初に柴田さんは現状を説明します。そこでCRI・ミドルウェアは、自動的に口パクデータを生成してくれるミドルウェア「ADX LipSync」を開発しています。

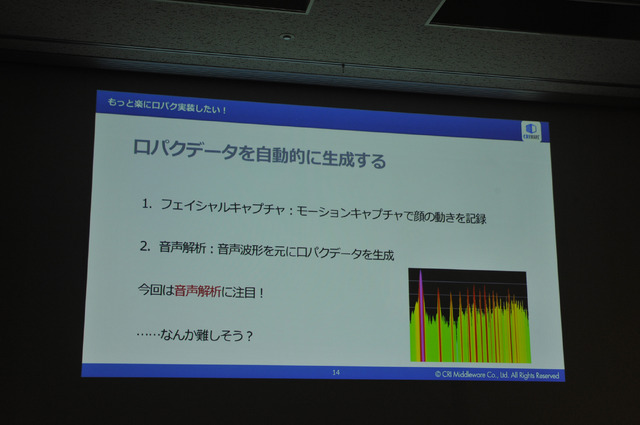

自動的に口パクデータを生成しようとした場合、大きく2つの方法があります。一つは、「フェイシャルキャプチャ」と呼ばれるもので、これはモーションキャプチャで顔の動きを読み取って記録し、そこから自動的に生成するものです。そしてもう一つが、音声解析というもので、音声波形を解析して口パクデータを自動生成するという方法です。「ADX LipSync」でも音声解析の方法を採用しています。

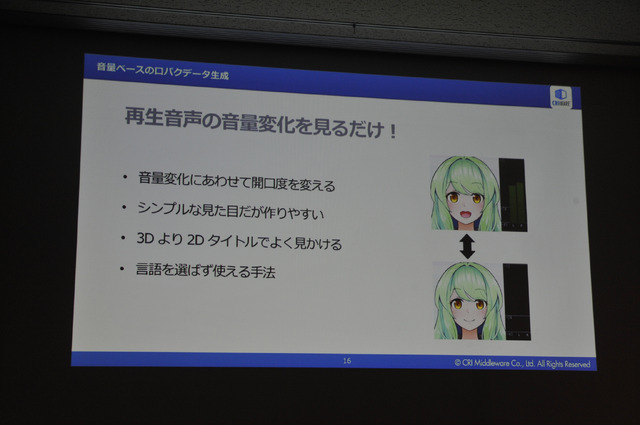

音声解析方式のメリットは、音量変化に合わせて口の開く度合いを変えることができる点や、シンプルであるという点、2Dタイトルでも応用が効く点などが挙げられます。

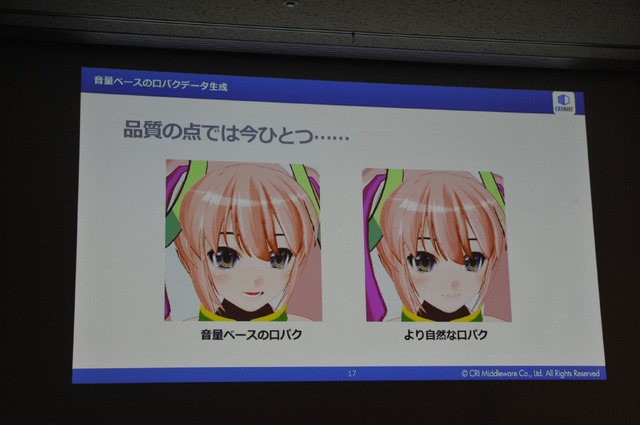

音声解析には「音量ベース」と「フォルマントベース」の大きく2つの方法があります。「音量ベース」は音量変化に合わせて口の開く度合いを変えるというものです。シンプルがゆえに作りやすく、言語を選ばず使えるのが特徴です。しかしながら単純である反面、口パクのリアリティという品質面では「フォルマントベース」に劣ります。

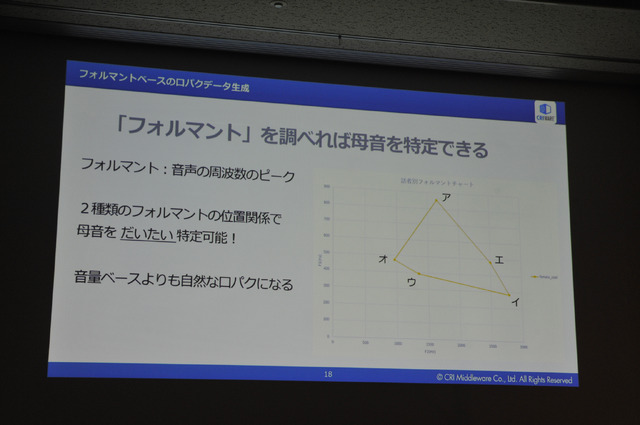

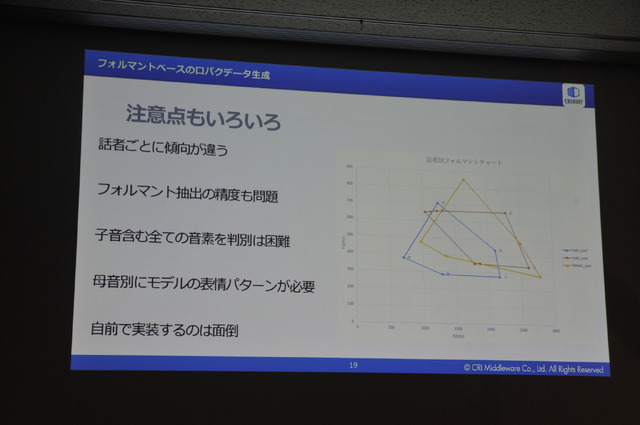

一方の「フォルマントベース」は、音声の周波数のピークから、母音を大まかに読み取る形式です。「音量ベース」よりも自然な口パクになる点で優れています。しかしながら、話者ごとに波形が異なる点や、波形の抽出の精度が問題となってきます。また、よりリアルな口パクの表現が可能になる反面、その分多くの表情パターンを用意する必要があります。そのため自前で実装するのに手間がかかるデメリットもあります。

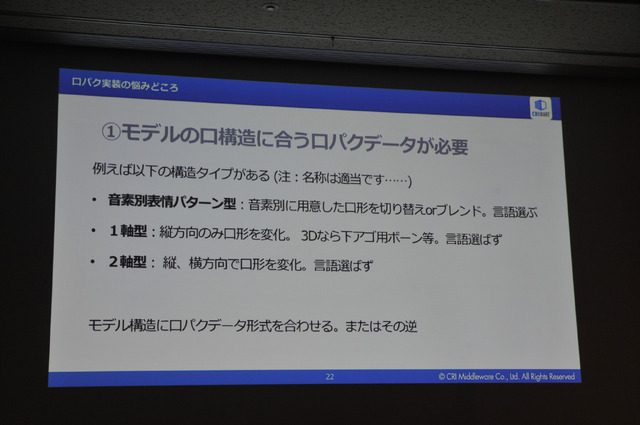

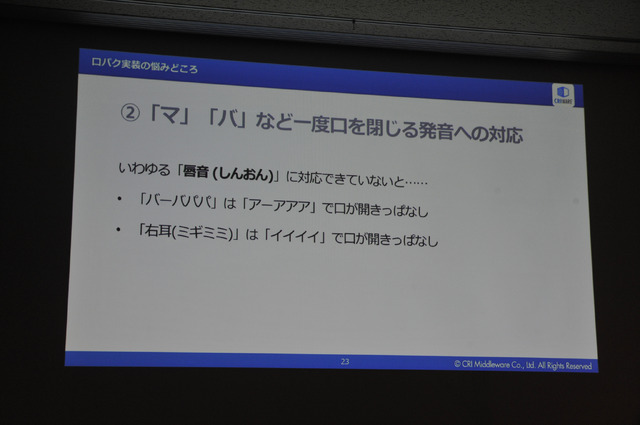

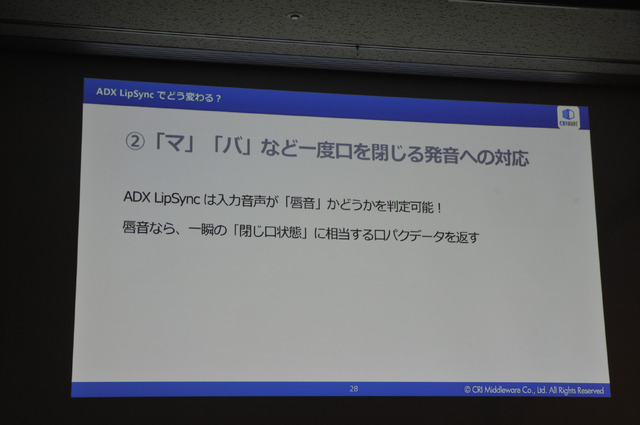

口パクデータを実装するにあたっては、いくつか課題もあります。まず、「マ」や「バ」など、一度口を閉じる発音、すなわち「唇音」への対応が挙げられます。母音ベースだけで口を動かしてしまうと、例えば「バーバパパ」は「アーアアア」となり、「右耳」は「いいいい」となってしまうため、本来は口を一瞬閉じて表現されるべきものが、開きっぱなしになってしまうのです。

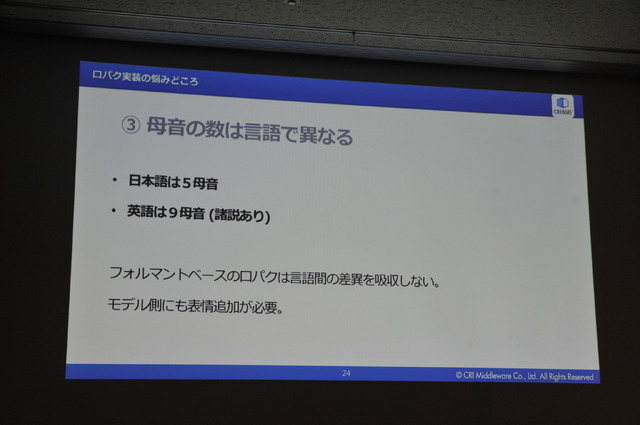

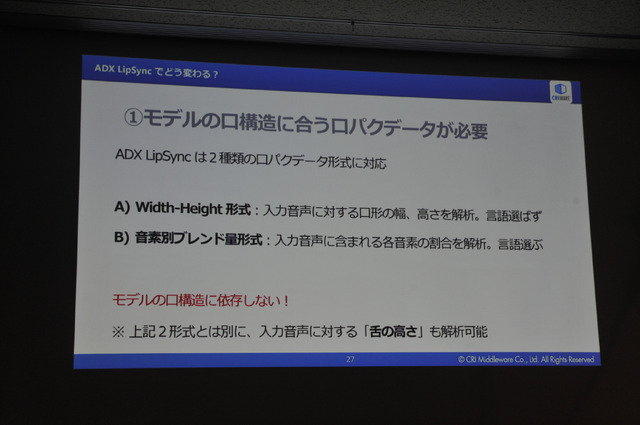

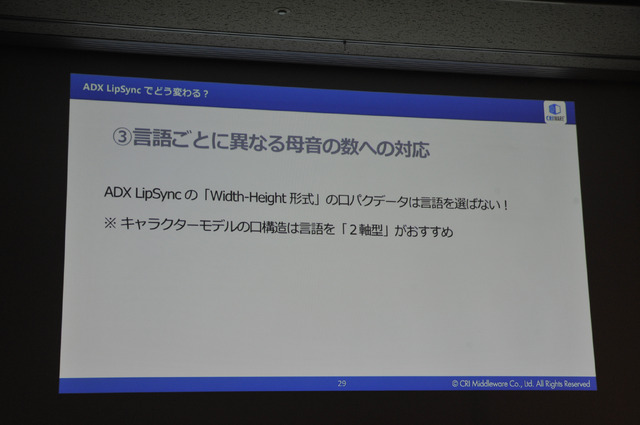

また、「フォルマントベース」においては母音の数が言語によって異なる点も問題となってきます。例えば日本語は5母音ですが、英語は一般的に9母音といわれています。「音量ベース」では言語間の互換性を持つものの、母音を基にする「フォルマントベース」では言語ごとに異なった対策が求められます。また、母音の数によってモデルの表情の追加も必要になってきます。

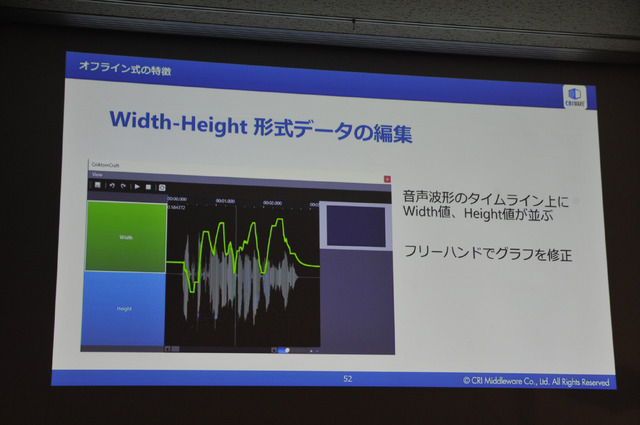

こうしたリップシンクの導入コストを「ADX LipSync」では軽減しています。「マ」や「バ」などの唇音では一度口を閉じる対応を自動的に判別してくれるほか、実際の口の動きに対しても、入力音声に対して口の形の幅や高さを解析して動かす「Width-Height形式」を採用する場合には言語を選ばないものとなっています。

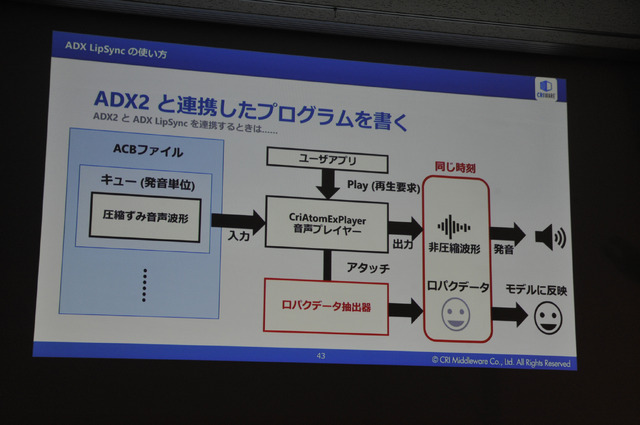

リアルタイムで音声再生と同時に口パクデータを作成することや、先にオフラインで口パクデータを生成しておいてそれを同期させることも可能です。リアルタイム方式の場合、解析精度という点では品質に限界があり、再生環境に負荷がかかる欠点がありますが、オフライン方式の場合は予め解析してあるため、こうした負荷をなくすことができます。

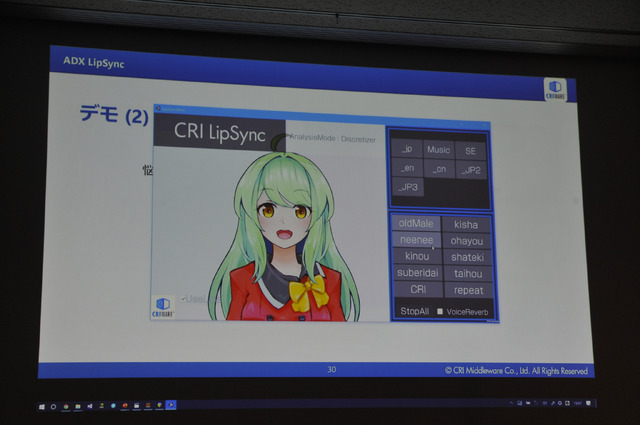

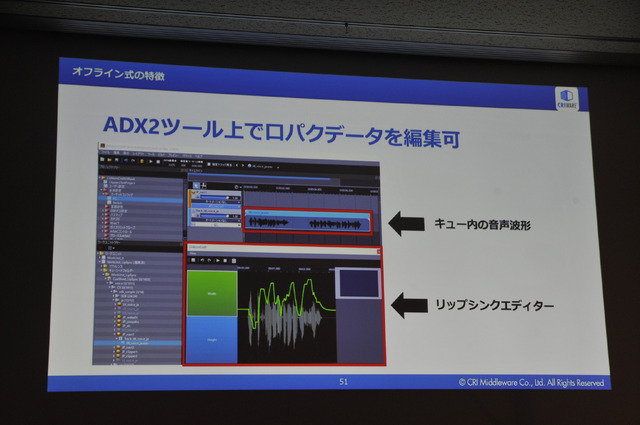

事前に作成・解析済みの口パクデータは、同社が提供する「ADX2ツール」を使って編集可能です。口の動きは実際のゲーム画面のプレビューで確認することができるほか、ゲームアプリケーションと接続してリアルタイムに編集することもできます。こうした口パクデータは多言語に対応しているだけでなく、キャラクターモデルに依存しない出力形式となっており、例えば男性の声を女性キャラクターに喋らせてもそのまま同じように口を動かすことができます。

「ADX LipSync」は、今年秋のリリースを予定して現在開発が進められています。価格は別途相談となっていますが、「ADX2ツール」と一緒に導入することで、シンプルなAPI&編集インターフェイスを目指しています。

柴田さんは口パクことリップシンクについて、「キャラクターの魅力をアップするための表情付けの一環。口パク表現をやるかやらないかによってキャラクターの存在感や実在感の演出に欠かせないもの」と力説します。リップシンク技術は、まさにキャラクターに息を吹き込むことなのかもしれませんね。